基于激光扫描仪的移动机器人深度相机内参标定方法

点击上方“计算机视觉life”,选择“星标”

快速获得最新干货

标题:Intrinsic Calibration of Depth Cameras for Mobile Robots using a Radial Laser Scanner

作者:David Zu~niga-Noel, Jose-Raul Ruiz-Sarmiento, and Javier Gonzalez-Jimenez

来源:arxiv 2019

播音员:

编译:赵键

审核:万应才,李鑫

摘要

大家好,今天为大家带来的文章是--Intrinsic Calibration of Depth Cameras for Mobile Robots using a Radial Laser Scanner 该文章2019年发表于https://arxiv.org /abs/1907.01839。

作者该文提出了一种基于2D激光扫描仪与低成本RGBD相机的融合深度标定校正方法,该方法巧妙的利用了目前普遍配置在移动机器人上的2D激光扫描仪和RGBD相机来对深度相机进行内参标定,能有效的校正深度相机的局部形变和全局误差,其方法快捷精确,且无需任何外在的标定板或标志物。因此,具有较强的工程实用性和有效性,代码已开源于https://github.com/dzunigan/depth_calibration,相关测试数据下载地址为 :https://doi.org/10.5281/zenodo.2636878。

主要贡献

1.本文所提标定方法不需要任何标定板或标志物,因此能在移动机器人平台上实现快捷自动的应用;

2.将结构光深度相机的系统深度测量误差用更为简洁的参数化表示方法来表达,即通过最大似然估计框架来表示测量偏差函数;

3.该标定方法的输出为逐像素的二次偏差函数,因此可用实时方式同时实现深度相机的局部形变和全局测量系统误差的校正。

算法流程

1、深度误差模型:

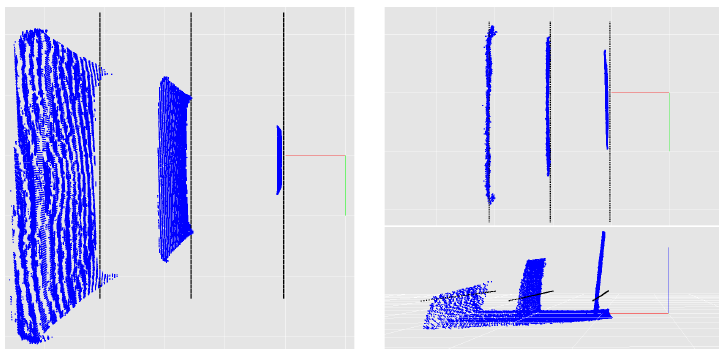

图1 深度相机随着成像距离增加而呈现的系统误差,左图为深度相机对垂直墙面在1-4m距离上的观测结果。右图为深度相机俯仰60度后同一墙面的观测结果。

如图1所示,结构光RGBD相机的系统误差主要来源于两种误差,即局部形变和全局误差。其中,局部形变表现为点云出现的非线性的形变,而全局误差则是指随着成像距离增加,测量的平均深度会相比于真实距离存在着整体上的偏差。我们可将两种来源的误差用深度偏差来表示:

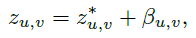

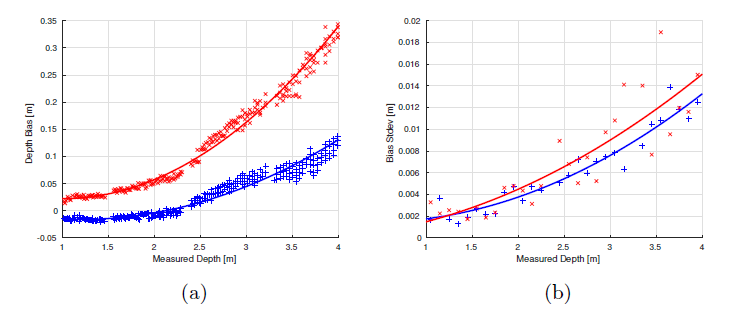

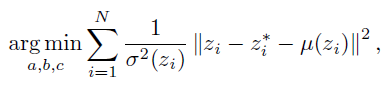

图2 两个不同像素处的观测偏差(2a)与偏差噪声(2b)与测量深度值之间的二次曲线拟合结果

图2a中给出了通过计算不同像素处的测量深度值与对应的真实深度值所得到的偏差与测量深度值之间的函数关系,可见每个像素处都具有不同的偏差值,但整体可通过一个二次方程来拟合其与测量值之间的关系。但如果我们利用偏差的标准差来表示,如图2b所示,不同于偏差,测量偏差的不确定性对于不同像素而言却是近似相同的,因此我们可以用一个方差函数来表示所有像素处的误差。最后,系统深度误差可以用以下公式来表示:

2、标定方法:

2.1 基准深度的计算:

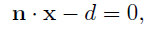

标定方法的输入值是深度相机和激光扫描仪对同一个垂直平面的观测值,深度相机得到的是深度图像,而激光扫描仪则用几何参数形式来表达观测到的平面:

设深度相机和激光扫描仪的外参参数为(R,t),则可通过外参将激光扫描仪的坐标系转换到深度相机坐标系下:

由深度图像和内参可得到三维点坐标,这样可最终得到每个像素下的测量和基准深度值对。

2.2 偏差函数的最大似然估计:

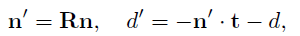

一旦计算得到了深度测量-基准数据对后,估计偏差函数主要分为两步:首先,对所有像素可对观测的方差进行二次函数拟合,其次,再对每个像素独立的计算实际的偏差参数。

首先,估计偏差噪声的最佳二次函数的参数,可利用最小二乘方法来求解:

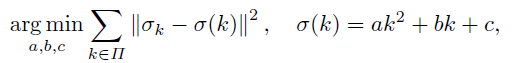

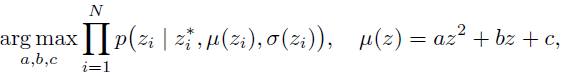

在估计了偏差不确定性的参数后,可针对每个像素来求解偏差函数的二次估计拟合的参数。本文中就将标定问题用最大似然估计函数的形式来表示如下:

将上式取负对数可得到下列等同的最小二乘问题:

这样通过求解上式(12),我们可估计初在每个像素处测量深度值所对应的偏差函数。

主要结果

图3. 左图为实验所采取的Giraff机器人及其所安装的传感器,右图为机器人面对墙面进行标定数据的采集

如图3所示,基于Giraff机器人系统,采集了两个RGBD相机(奥比中光)和一个2D激光扫描仪(Hokuyo URG04LX-UG01)的数据。在采集过程中,让机器人朝向一睹平面墙体来回往返运动,同时记录下各个传感器的测量数据。为了可复现我们的标定结果,采集的数据可在https://doi.org/10.5281/zenodo.2636878下载。

1、定量分析:

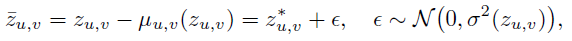

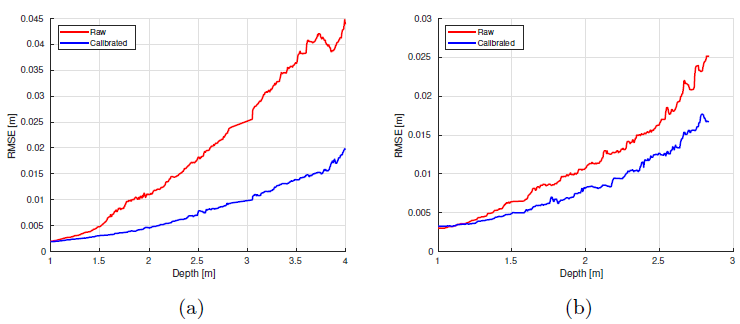

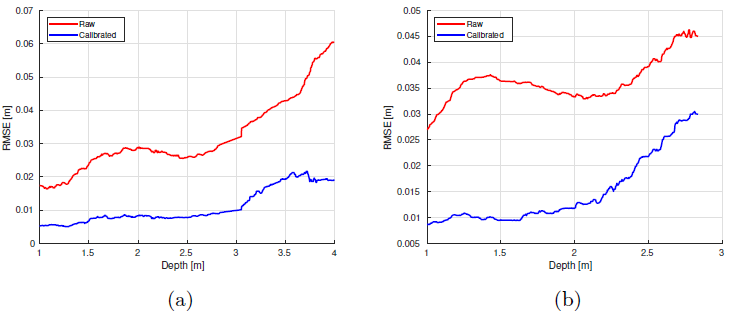

图4 两个RGBD相机局部形变校正效果对比(a为安装在上面的RGBD相机,b为安装在下面的RGBD相机)

由图4可见,相比于原始的深度测量值,经过本文标定方法校正后的局部深度测量值均得到了较大的精度提升。

图5 两个RGBD相机全局误差校正效果对比(a为安装在上面的RGBD相机,b为安装在下面的RGBD相机)

由图5可见,相比于原始的深度测量值,经过本文标定方法校正后的全局的深度测量值均得到了较大的精度提升。

2、定性分析

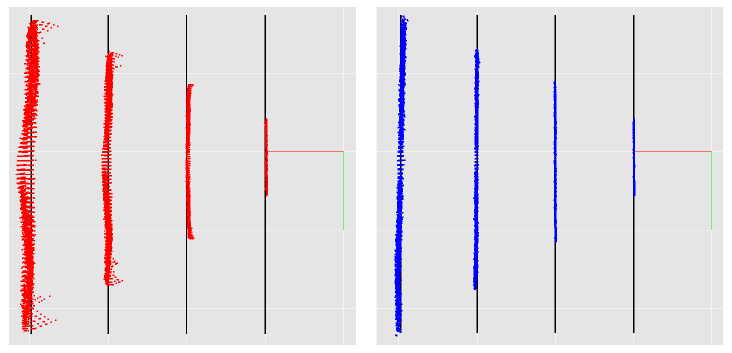

由图6可见,原始的深度测量值如右图所示,而左图为经过本文标定校正后的数据,可见,无论近距离还是远距离情况下,本文方法均能将局部形变和全局误差减少,对精度的提升有明显的效果。

图6 左图为原始数据所成的平面点云数据,右图为标定校正后的数据,基准平面为1-4m的黑色直线

Abstract

Depth cameras, typically in RGB-D congurations, are common devices in mobile robotic platforms given their appealing features: high frequency and resolution, low price and power requirements, among others. These sensors may come with signicant, non-linear errors inthe depth measurements that jeopardize robot tasks, like free-space detection,environment reconstruction or visual robot-human interaction. This paper presents a method to calibrate such systematic errors with the help of a second, more precise range sensor, in our case a radial laser scanner. In contrast to what it may seem at rst, this does not mean a serious limitation in practice since these two sensors are often mounted jointly in many mobile robotic platforms, as they complement well each other. Moreover, the laser scanner can be used just for the calibration process and get rid of it after that. The main contributions of the paper are: i) the calibration is formulated from a probabilistic perspective through a Maximum Likelihood Estimation problem, and ii) the proposed method can be easily executed automatically by mobile robotic platforms. To validate the proposed approach we evaluated for both, local distortion of 3D planar reconstructions and global shifts in the measurements, obtaining considerably more accurate results. A C++ open-source implementation of the presented method has been released for the benet of the community.

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、检测分割识别、三维视觉、医学影像、GAN、自动驾驶、计算摄影、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~

投稿、合作也欢迎联系:simiter@126.com

长按关注计算机视觉life

推荐阅读

从零开始一起学习SLAM | 不推公式,如何真正理解对极约束?

从零开始一起学习SLAM | 理解图优化,一步步带你看懂g2o代码

从零开始一起学习SLAM | 用四元数插值来对齐IMU和图像帧

最新AI干货,我在看