谷歌搜索用上BERT,10%搜索结果将改善

选自谷歌博客

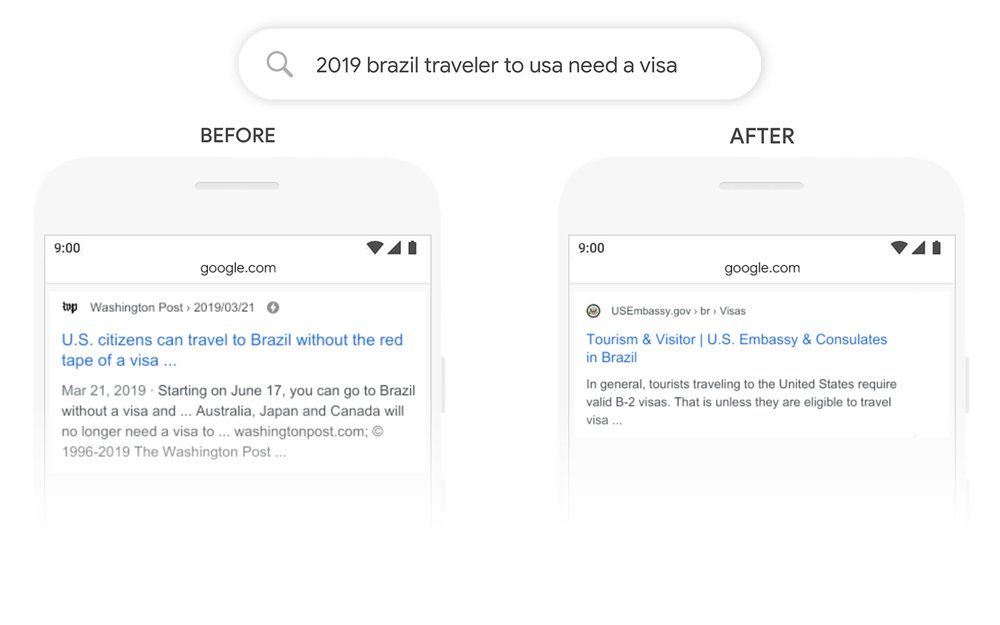

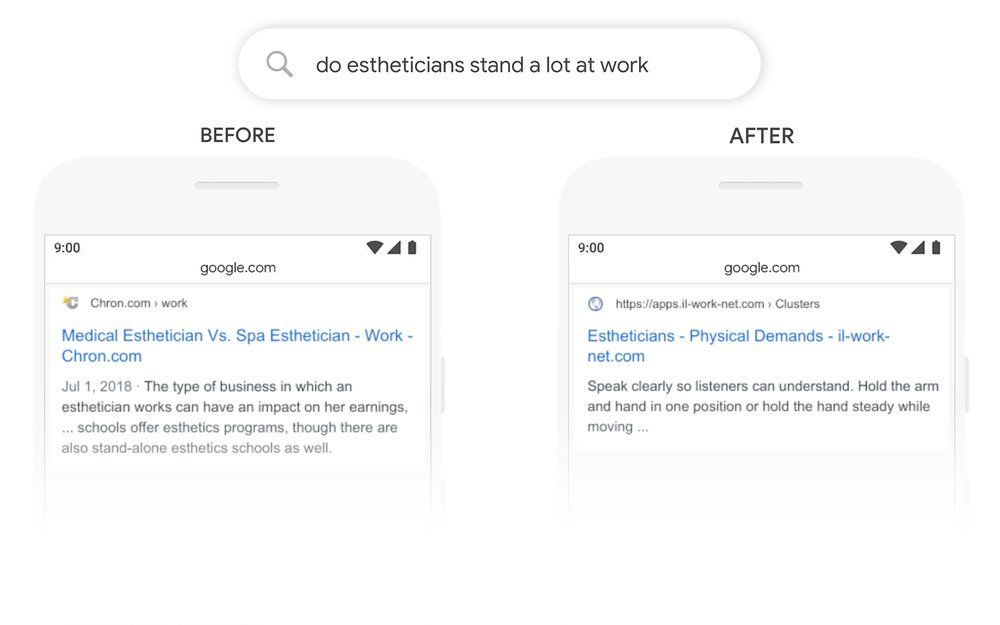

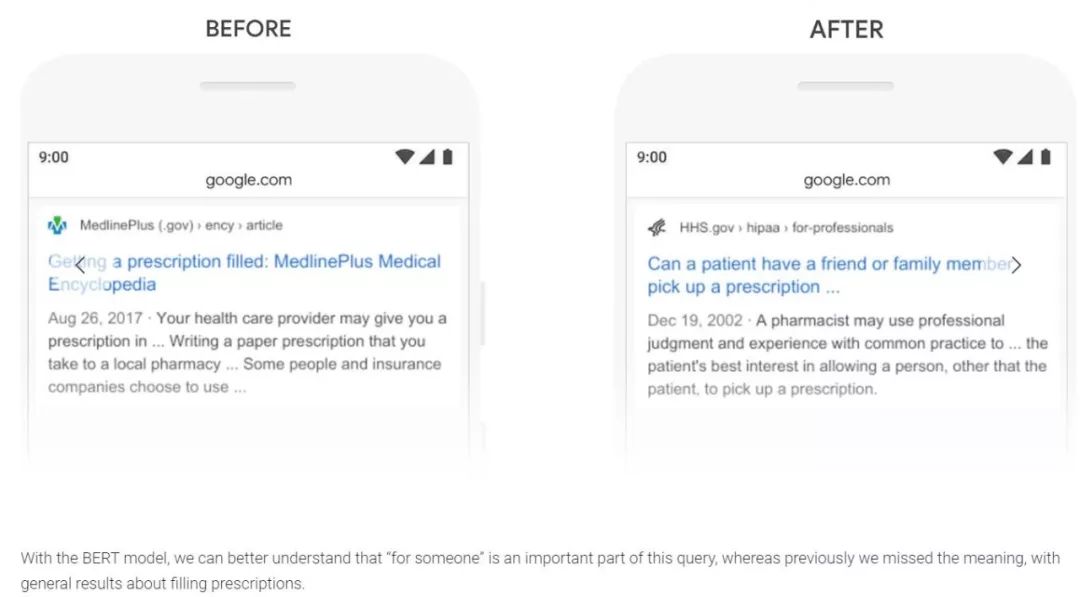

如何让搜索引擎呈现用户想要的结果是困扰谷歌工程师的一大难题。 最近,谷歌宣布,他们的搜索引擎用上了强大的 BERT 预训练模型,可以让搜索引擎结合语境理解用户的搜索意图,甚至能理解一些不起眼的介词在搜索语句中的重要含义。 有了 BERT 的加持,用户能在谷歌中搜到相关性更强的结果。

登录查看更多

相关内容

专知会员服务

29+阅读 · 2020年5月20日

专知会员服务

12+阅读 · 2019年11月26日

Arxiv

14+阅读 · 2018年10月11日