题目: A Transformer-based Embedding Model for Personalized Product Search

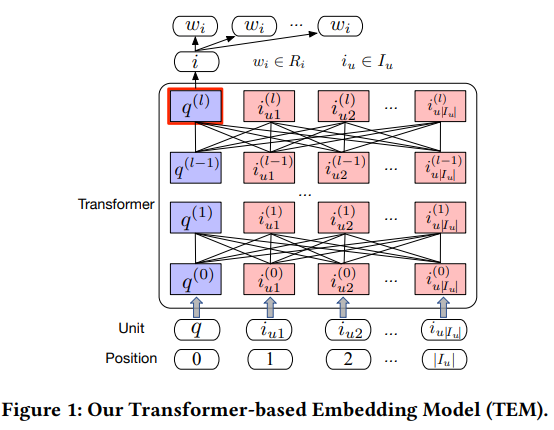

摘要: 产品搜索是人们在电子商务平台上浏览和购买商品的重要方式。虽然客户倾向于根据他们的个人品味和偏好做出选择,但对商业产品搜索日志的分析表明,个性化并不总是能提高产品搜索质量。然而,大多数现有的产品搜索技术在搜索会话之间执行无差异的个性化设置。他们要么用一个固定的系数来控制个性化的影响,要么用一个注意力机制让个性化一直发挥作用。唯一值得注意的例外是最近提出的零注意模型(zero-attention model, ZAM),该模型允许查询关注一个零向量,从而自适应地调整个性化的效果。尽管如此,在ZAM中,个性化最多可以发挥与查询同等重要的作用,并且不管用户的历史购买中同时出现的item是什么,item的表示在整个集合中都是静态的。考虑到这些局限性,我们提出了一种基于Transformer的个性化产品搜索嵌入模型(TEM),该模型通过使用Transformer架构对查询序列和用户购买历史进行编码,从而动态地控制个性化的影响。个性化可以在必要时发挥主导作用,在计算注意力权重时可以考虑item之间的交互。实验结果表明,TEM的性能明显优于目前最先进的个性化产品检索模型。

成为VIP会员查看完整内容

相关内容

Transformer是谷歌发表的论文《Attention Is All You Need》提出一种完全基于Attention的翻译架构

专知会员服务

28+阅读 · 2020年2月12日