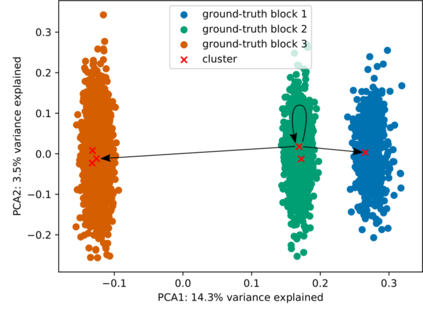

Abstraction is crucial for effective sequential decision making in domains with large state spaces. In this work, we propose an information bottleneck method for learning approximate bisimulations, a type of state abstraction. We use a deep neural encoder to map states onto continuous embeddings. We map these embeddings onto a discrete representation using an action-conditioned hidden Markov model, which is trained end-to-end with the neural network. Our method is suited for environments with high-dimensional states and learns from a stream of experience collected by an agent acting in a Markov decision process. Through this learned discrete abstract model, we can efficiently plan for unseen goals in a multi-goal Reinforcement Learning setting. We test our method in simplified robotic manipulation domains with image states. We also compare it against previous model-based approaches to finding bisimulations in discrete grid-world-like environments. Source code is available at https://github.com/ondrejba/discrete_abstractions.

翻译:抽象化对于在有较大国家空间的领域有效进行连续决策至关重要。 在这项工作中, 我们提议了一种信息瓶颈方法, 用于学习近似闪烁, 一种状态抽象。 我们使用深神经编码器将状态映射到连续嵌入中。 我们用一个以行动为条件的隐藏 Markov 模型将这些嵌入到一个离散的表示器上, 该模型是经过神经网络培训的端对端模式。 我们的方法适合具有高维度状态的环境, 并学习由在Markov 决策过程中行事的代理人收集的一流经验。 通过这一学习的离散抽象模型, 我们可以在多目标强化学习环境中有效地规划不可见的目标。 我们用图像状态测试我们在简化机器人操纵域中的方法。 我们还将它与以往在离散电网- 世界类似环境中寻找刺激的模型方法进行比较。 源代码可在 https://github.com/ ondrejba/ discrete_ abstractions 上查阅 。