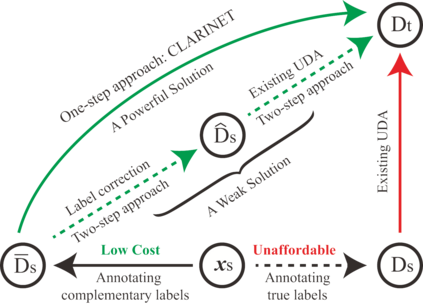

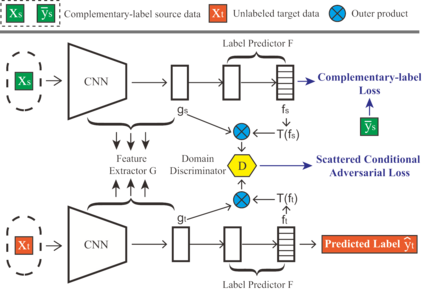

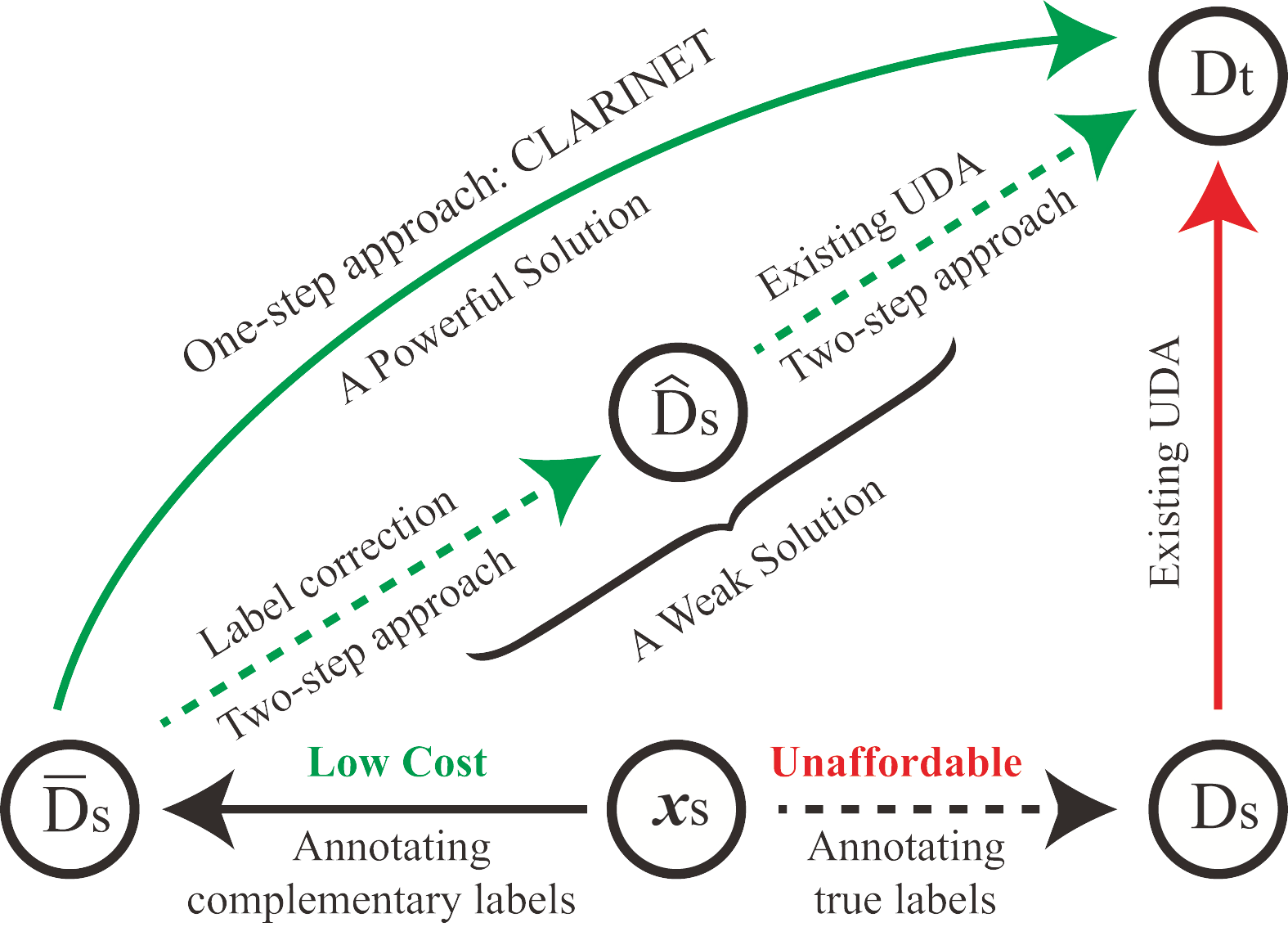

In unsupervised domain adaptation (UDA), classifiers for the target domain are trained with massive true-label data from the source domain and unlabeled data from the target domain. However, it may be difficult to collect fully-true-label data in a source domain given a limited budget. To mitigate this problem, we consider a novel problem setting where the classifier for the target domain has to be trained with complementary-label data from the source domain and unlabeled data from the target domain named budget-friendly UDA (BFUDA). The key benefit is that it is much less costly to collect complementary-label source data (required by BFUDA) than collecting the true-label source data (required by ordinary UDA). To this end, the complementary label adversarial network (CLARINET) is proposed to solve the BFUDA problem. CLARINET maintains two deep networks simultaneously, where one focuses on classifying complementary-label source data and the other takes care of the source-to-target distributional adaptation. Experiments show that CLARINET significantly outperforms a series of competent baselines.

翻译:在未监督的域适应(UDA)中,目标域的分类人员接受来自源域的大量真实标签数据和来自目标域的无标签数据的培训。然而,由于预算有限,在源域可能难以收集完全真实标签数据。为了缓解这一问题,我们考虑一种新的问题设置,即目标域的分类人员必须接受来自源域的补充标签数据培训,目标域的分类人员必须接受来自目标域的名称为预算友好UDA(BFUDA)的无标签数据培训。关键的好处是,收集补充标签源数据(BFUDA要求的)比收集真实标签源数据(普通UDA要求的)的费用要低得多。为此,建议补充标签对抗网络(LARInet)解决BFUDA问题。LARINET同时维持两个深度网络,其中一个侧重于对补充标签源数据进行分类,另一个侧重于源对目标分配适应。实验显示, LALRINET明显超出一系列胜任的基准。