题目: Hierarchical Knowledge Graphs: A Novel Information Representation for Exploratory Search Tasks

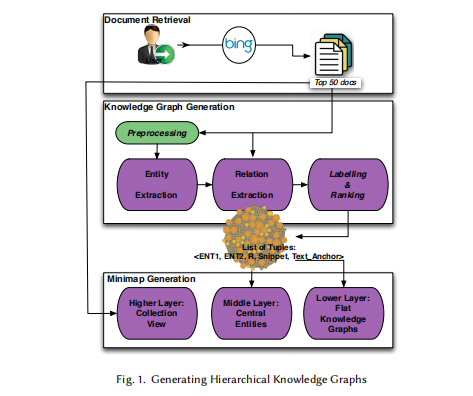

简介: 在探索性搜索任务中,除了信息检索之外,信息表示是有意义的重要因素。在本文中,我们探索了知识图的多层扩展,即层次知识图(HKG),它将层次化和网络可视化结合为统一的数据表示形式,作为支持探索性搜索工具。我们将描述我们的算法,以构建可视化效果,分析结果以定量地展示与网络的性能奇偶性以及相对于层次结构的性能优势,并从交互日志,interviews和thinkalouds的数据综合到测试平台数据集上,以证明统一的分层结构+ HKG中的网络结构。除了上述研究,我们还对精度和召回率对两种不同的探索性搜索任务的层次知识图的性能进行了其他混合方法分析。虽然定量数据显示精确度和召回率对用户性能和用户工作量的影响有限,但定性数据与事后统计分析相结合提供了证据,表明探索性搜索任务的类型(例如学习与调查)可能会受到精确度和召回影响。此外,我们的定性分析发现用户无法感知所提取信息的质量差异。我们讨论了结果的含义,并分析了在实验任务中对探索性搜索性能产生更大影响的其他因素。

成为VIP会员查看完整内容

相关内容

知识图谱(Knowledge Graph),在图书情报界称为知识域可视化或知识领域映射地图,是显示知识发展进程与结构关系的一系列各种不同的图形,用可视化技术描述知识资源及其载体,挖掘、分析、构建、绘制和显示知识及它们之间的相互联系。

知识图谱是通过将应用数学、图形学、信息可视化技术、信息科学等学科的理论与方法与计量学引文分析、共现分析等方法结合,并利用可视化的图谱形象地展示学科的核心结构、发展历史、前沿领域以及整体知识架构达到多学科融合目的的现代理论。它能为学科研究提供切实的、有价值的参考。

专知会员服务

59+阅读 · 2020年6月30日

专知会员服务

47+阅读 · 2020年6月3日

Arxiv

20+阅读 · 2019年12月19日

Arxiv

3+阅读 · 2019年2月26日