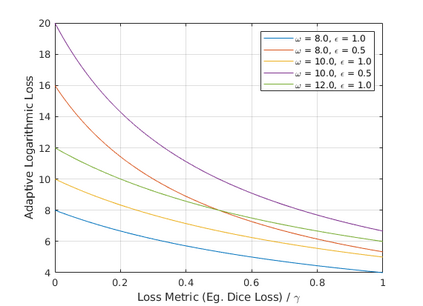

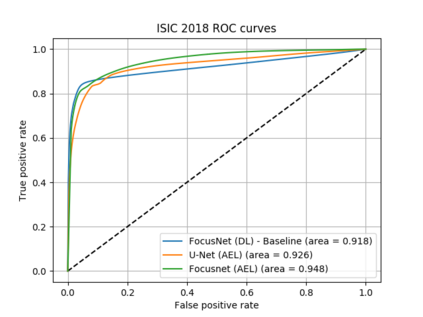

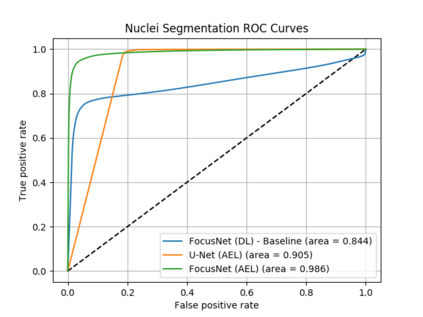

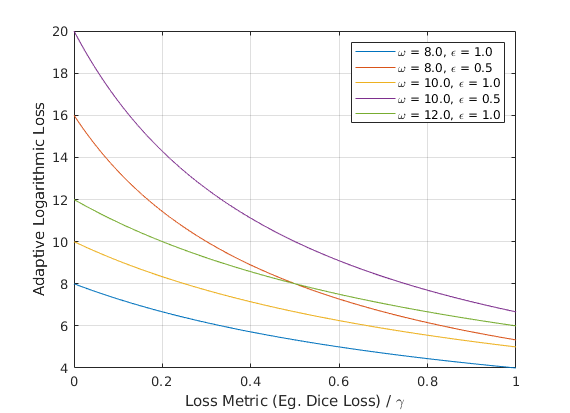

Loss functions are error metrics that quantify the difference between a prediction and its corresponding ground truth. Fundamentally, they define a functional landscape for traversal by gradient descent. Although numerous loss functions have been proposed to date in order to handle various machine learning problems, little attention has been given to enhancing these functions to better traverse the loss landscape. In this paper, we simultaneously and significantly mitigate two prominent problems in medical image segmentation namely: i) class imbalance between foreground and background pixels and ii) poor loss function convergence. To this end, we propose an adaptive logarithmic loss function. We compare this loss function with the existing state-of-the-art on the ISIC 2018 dataset, the nuclei segmentation dataset as well as the DRIVE retinal vessel segmentation dataset. We measure the performance of our methodology on benchmark metrics and demonstrate state-of-the-art performance. More generally, we show that our system can be used as a framework for better training of deep neural networks.

翻译:损失函数是量化预测与其相应的地面事实之间的差别的错误度量。 从根本上说, 它们界定了一种因梯度下降而跨度的功能景观。 虽然迄今为止已经提出了许多损失功能, 以便处理各种机器学习问题, 但很少注意加强这些功能, 以便更好地绕过损失景观。 在本文中, 我们同时并显著地缓解了医学图像分割的两个突出问题, 即: (一) 地表和背景像素之间的等级不平衡, 以及 (二) 损失函数的差异。 为此, 我们提议了一个适应性对数损失函数。 我们把这个损失函数与国际标准行业分类 2018 数据集、 核分离数据集 和 流体对流体对流数据集的现有最新技术进行比较。 我们测量了我们衡量基准度方法的性能, 并展示了最新性性能。 更一般地说, 我们表明, 我们的系统可以用作一个框架, 更好地培训深神经网络。